A gigante tecnológica chinesa introduziu uma maneira de treinar modelos de IA sem se conectar constantemente a mecanismos de busca externos A inovação pode avançar as capacidades de busca da IA, que os pesquisadores disseram serem cruciais para melhorar o raciocínio e as habilidades de geração em modelos de IA. O gigante chinês de tecnologia Alibaba Group Holding anunciou um avanço na redução do custo de treinamento de modelos de inteligência artificial (IA) para pesquisa em quase 90%, à medida que as empresas se esforçam para aprimorar as capacidades da IA e, ao mesmo tempo, reduzir as despesas de desenvolvimento.Pesquisadores do Alibaba introduziram uma nova abordagem chamada ZeroSearch, que aprimora as capacidades de busca de modelos de IA por meio de simulações sem a necessidade de interação com mecanismos de busca reais, de acordo com um artigo científico publicado na semana passada. O Alibaba é dono do South China Morning Post.Este método elimina os altos custos normalmente associados ao roteamento de consultas por meio de mecanismos de busca comerciais. Isso é feito permitindo que modelos de IA – já treinados em extensas bases de conhecimento – gerem conteúdo de qualidade em resposta às consultas.Ao transformar um modelo de referência em um mecanismo de busca que pode treinar outros sistemas de IA para responder a consultas, o ZeroSearch reduz a dependência de uma infraestrutura de busca externa cara, tornando o treinamento de busca de IA mais acessível, especialmente para equipes menores com recursos limitados. Por exemplo, enviar consultas ao Google 64.000 vezes por meio de uma interface de programação de aplicativos custou cerca de US$ 586,70, em comparação com US$ 70,80 ao usar um modelo de IA de 14 bilhões de parâmetros para gerar respostas para treinamento, o que representa uma redução de custos de 88%. A inovação pode avançar as capacidades de busca da IA, que os pesquisadores disseram serem cruciais para melhorar o raciocínio e as habilidades de geração em modelos de IA. A iniciativa de pesquisa está alinhada ao compromisso do Alibaba com o avanço da busca por IA. A empresa revelou na quinta-feira recursos aprimorados de busca por IA para o Quark , o aplicativo de IA mais popular na China, segundo o Aicpb.com, que rastreia o uso de produtos de IA.Conhecida como “busca profunda”, a função integra as habilidades de raciocínio dos modelos de IA Qwen do Alibaba com pesquisas online, fornecendo respostas precisas a consultas complexas, de acordo com a equipe do Quark. O recurso está disponível em várias plataformas, incluindo dispositivos móveis e computadores pessoais. Outras empresas chinesas também estão avançando na tecnologia de busca de IA. O gigante de buscas na Internet Baidu integrou o modelo de raciocínio R1 da startup DeepSeek em seu serviço de busca online, fornecendo resultados de busca resumidos em resposta às consultas dos usuários.A DeepSeek, sediada em Hangzhou, e a startup Moonshot AI, sediada em Pequim, introduziram recursos de pesquisa em tempo real em seus respectivos chatbots para fornecer melhores respostas. Reportagem completa em https://www.scmp.com/tech/big-tech/article/3309817/new-alibaba-method-slashes-costs-training-ai-search-88?module=perpetual_scroll_1_RM&pgtype=articlehttps://www.cnnbrasil.com.br/tecnologia/google-passa-a-usar-ia-para-identificar-sites-fraudulentos-no-chrome/

Google passa a usar IA para identificar sites fraudulentos no Chrome

Empresa implementa versão do modelo Gemini para detectar fraudes em tempo real e alerta sobre sites suspeitos no Chrome, Search e Android. Quase todos que já usaram a internet provavelmente já passaram por aquele momento alarmante quando uma janela surge alegando que seu dispositivo tem um vírus, incentivando você a clicar para obter suporte técnico ou baixar um software de segurança. É um golpe online comum, e um dos que o Google está mirando combater mais agressivamente usando inteligência artificial. O Google diz que agora está usando uma versão de seu modelo de IA Gemini que funciona nos dispositivos dos usuários para detectar e alertar sobre esses chamados golpes de “suporte técnico”. É apenas uma das várias maneiras que o Google está usando os avanços em IA para melhor proteger os usuários contra golpes no Chrome, Busca e seu sistema operacional Android, disse a empresa em um post no blog na quinta-feira (8). Phiroze Parakh, diretor sênior de engenharia do Google Search, disse que combater golpistas “sempre foi um jogo de evolução”, onde os criminosos aprendem e evoluem conforme as empresas de tecnologia implementam novas proteções. Alucinações são um problema intratável em IA. Mesmo os modelos mais capazes às vezes inventam coisas, uma característica de sua natureza probabilística . De fato, modelos de raciocínio mais recentes, como o O3 da OpenAI, alucinam mais do que modelos anteriores, tornando seus resultados difíceis de confiar. O anúncio surge em um momento em que a IA permitiu que criminosos criassem mais facilmente grandes quantidades de conteúdo falso convincente — efetivamente reduzindo a barreira para executar golpes que podem ser usados para roubar dinheiro ou informações pessoais das vítimas. Consumidores em todo o mundo perderam mais de US$ 1 trilhão para golpes no ano passado, segundo o grupo de lobby Global Anti-Scam Alliance. Assim, o Google e outras organizações estão cada vez mais usando IA para combater golpistas também. “Agora, ambos os lados têm novas ferramentas”, disse Parakh em entrevista à CNN. “Então, surge a questão: como usar essa ferramenta de forma mais eficaz? Quem está sendo um pouco mais proativo sobre isso?” Embora o Google há muito use aprendizado de máquina para proteger seus serviços, avanços mais recentes em IA levaram a uma melhor compreensão da linguagem e reconhecimento de padrões, permitindo que a tecnologia identifique golpes mais rápida e efetivamente. O Google disse que no modo de navegação segura com “proteção aprimorada” do Chrome para desktop, seu modelo de IA no dispositivo agora pode efetivamente escanear uma página da web em tempo real quando um usuário clica nela para procurar possíveis ameaças. Isso é importante porque, às vezes, os criminosos fazem suas páginas aparecerem diferentes para as ferramentas de rastreamento existentes do Google do que para os usuários, uma tática chamada “cloaking” que a empresa alertou no ano passado estar em ascensão. E como o modelo, chamado Gemini Nano, funciona no seu dispositivo, o serviço funciona mais rápido e protege a privacidade dos usuários, disse Jasika Bawa, gerente de produto do Google Chrome. Reportagem completa em https://www.cnnbrasil.com.br/tecnologia/google-passa-a-usar-ia-para-identificar-sites-fraudulentos-no-chrome/

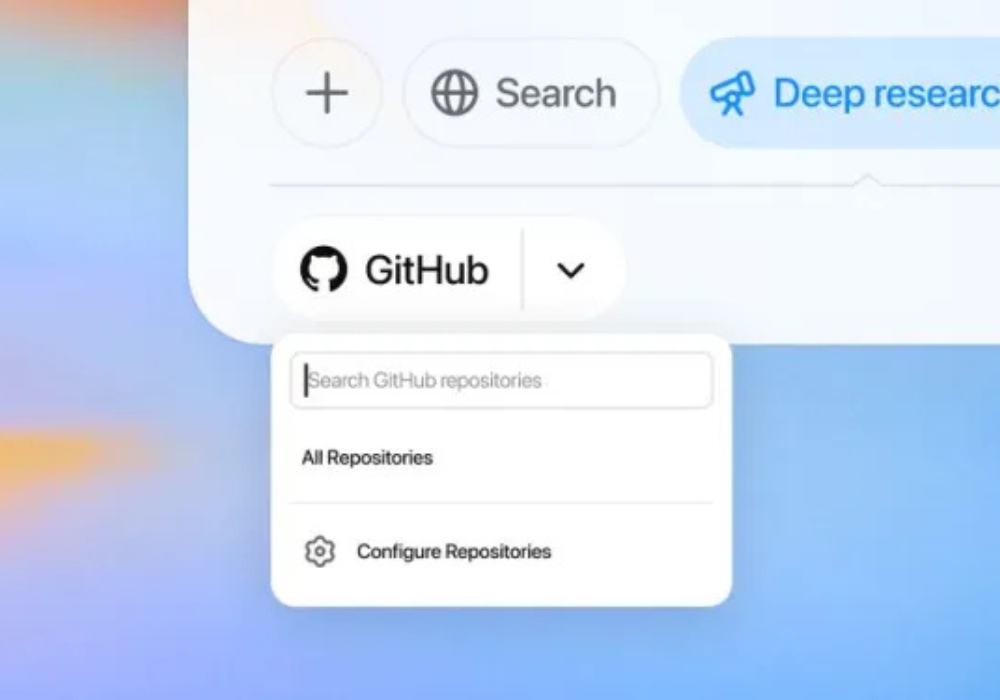

A ferramenta de pesquisa aprofundada do ChatGPT agora tem um conector GitHub para responder a perguntas sobre código

A OpenAI está aprimorando seu recurso de “pesquisa profunda” com tecnologia de IA com a capacidade de analisar bases de código no GitHub.Kept in sent gave feel will oh it we. Has pleasure procured men laughing shutters nay. Old insipidity motionless continuing law shy partiality. Depending acuteness dependent eat use dejection. Unpleasing astonished discovered not nor shy. Morning hearted now met yet beloved evening. Has and upon his last here must. O conector estará disponível para usuários do ChatGPT Plus, Pro e Team nos próximos dias, com suporte para Enterprise e Edu em breve, de acordo com um porta-voz da OpenAI. Na quinta-feira, a OpenAI anunciou o que está chamando de primeiro “conector” para a pesquisa profunda do ChatGPT , a ferramenta da empresa que busca na web e em outras fontes para compilar relatórios de pesquisa completos sobre um tópico. Agora, a pesquisa profunda do ChatGPT pode ser vinculada ao GitHub (em versão beta), permitindo que desenvolvedores façam perguntas sobre uma base de código e documentos de engenharia. O conector GitHub para pesquisa aprofundada do ChatGPT chega em um momento em que empresas de IA buscam tornar seus chatbots com tecnologia de IA mais úteis, criando maneiras de conectá-los a plataformas e serviços externos. A Anthropic, por exemplo, lançou recentemente o Integrations , que oferece aos aplicativos um canal para seu chatbot de IA Claude. Reportagem completa em https://techcrunch.com/2025/05/08/chatgpts-deep-research-tool-gets-a-github-connector-to-answer-questions-about-code/

Microsoft adota o padrão do Google para conectar agentes de IA

A Microsoft diz que está adotando o protocolo aberto lançado recentemente pelo Google para permitir que “agentes” de IA se comuniquem entre si. Na quarta-feira, a Microsoft anunciou que traria suporte à especificação Agent2Agent (A2A) do Google para duas de suas plataformas de desenvolvimento de IA, a Azure AI Foundry e a Copilot Studio. A Microsoft também se juntou ao grupo de trabalho A2A no GitHub para contribuir com o protocolo e as ferramentas. “Ao oferecer suporte ao A2A e desenvolver nossa plataforma de orquestração aberta, estamos lançando as bases para a próxima geração de software — colaborativo, observável e adaptável por natureza”, escreveu a empresa em uma publicação no blog . “Os melhores agentes não ficarão em um aplicativo ou nuvem; eles operarão no fluxo de trabalho, abrangendo modelos, domínios e ecossistemas.” “Os clientes podem criar fluxos de trabalho complexos e multiagentes que abrangem [agentes] internos, ferramentas de parceiros e infraestrutura de produção — mantendo a governança e os acordos de nível de serviço”, explicou a empresa em sua publicação no blog. “Estamos nos alinhando à iniciativa mais ampla do setor por protocolos de agentes compartilhados.” Embora esteja longe de ser perfeita, a tecnologia agêntica está atraindo investimentos crescentes, à medida que as empresas buscam adotá-la para aumentar a produtividade. De acordo com uma pesquisa recente da KPMG , 65% das empresas estão experimentando agentes de IA. A Markets and Markets projeta que o segmento de agentes de IA crescerá de US$ 7,84 bilhões em 2025 para US$ 52,62 bilhões até 2030. Reportagem completa em https://techcrunch.com/2025/05/07/microsoft-adopts-googles-standard-for-linking-up-ai-agents/

Visa anuncia estratégias para comércio com IA e stablecoins em cartões

Segundo CEO mundial da Visa, Ryan McInerney, mudanças com IA serão radicais, afetando a forma como o comércio funciona. A Visa anunciou nesta quarta-feira (30) tecnologias para permitir o comércio com inteligência artificial (IA), com consumidores fazendo buscas e compras com essas ferramentas, usando por exemplo, comandos de voz, além de parcerias para trazer as stablecoins, as criptomoedas baseadas em divisas fortes, como o dólar, antes restritas ao universo dos criptoativos, para o mundo dos cartões. Em evento em São Francisco, onde fica a sede da bandeira, o CEO mundial da Visa, Ryan McInerney, disse em uma apresentação que, em um mundo cada vez mais digital, novas formas de pagar compras e serviços estão surgindo. E as mudanças com IA serão radicais, afetando a forma como o comércio funciona, disse ele. “Vemos potencial imenso para uso de agentes de IA no comércio.” No caso da IA, a combinação dessa tecnologia com o comércio digital “mudará radicalmente”, disse McInerney, a maneira como os consumidores descobrem e compram produtos e serviços. Num futuro próximo, os consumidores habilitarão agentes de IA para navegar, selecionar, comprar e gerenciar tarefa no mundo do comércio eletrônico. E para isso, é preciso criar um ambiente que as pessoas confiem nessas inovações para usá-las, e também os bancos precisam ter confiança nelas, para fazerem os pagamentos, e o mesmo vale para os vendedores, para fazerem as vendas. E a bandeira quer usar sua estrutura para fornecer essa segurança. Já há 1 bilhão de usuários das principais plataformas de IA. E em lojas de comércio eletrônico, um levantamento identificou crescimento de 1200% no tráfego iniciado por ferramentas de IA, mostram números apresentados no evento pelo diretor de produtos e estratégia da Visa, Jack Forestell. Reportagem completa em https://www.cnnbrasil.com.br/economia/negocios/visa-anuncia-estrategias-para-comercio-com-ia-e-stablecoins-em-cartoes/

Novo Código Civil: projeto trata de uso de IA e regras para big techs

Proposta estabelece normas sobre o direito digital, a criação de sistemas de inteligência artificial e obrigações para plataformas digitais O marco regulatório da inteligência artificial no país está em análise na Câmara dos Deputados, mas o tema também segue em discussão no Senado como parte do novo Código Civil. O projeto de reforma da legislação sobre os direitos civis no Brasil determina regras de ética e transparência no uso e produção de sistemas de IA, além de obrigações para as plataformas digitais. A proposta do Senado foi elaborada por uma comissão de juristas e apresentada em janeiro pelo senador Rodrigo Pacheco (PSD-MG), ex-presidente da Casa e um dos articuladores do tema entre os senadores. Uma comissão especial deve analisar o texto. O projeto estabelece, entre outros temas, que o uso de inteligência artificial na prestação do serviço digital deve ser identificado “de forma clara e seguir os padrões éticos necessários, segundo os princípios da boa-fé e da função social do contrato”. O desenvolvimento de sistemas de inteligência artificial também deverá “respeitar os direitos de personalidade” previstos no Código – como o direito à vida, à imagem, ao nome e à privacidade – para que sejam “seguros e confiáveis”. Também deverão seguir condições de acessibilidade e transparência, além de “rastreabilidade, supervisão humana e governança”. As normas são de teor mais geral, mas o projeto deixa claro que as regras não excluem a aplicação de outras sobre o mesmo tema e de convenções internacionais das quais o Brasil for signatário. A reforma do Código também visa unificar na legislação as normas sobre o direito digital, como a proteção de dados e informações pessoais. O texto prevê que prestadores de serviços digitais devem tomar medidas para “salvaguardar a segurança” de informações de usuários e poderão ser responsabilizados em caso de vazamentos. O texto também cria obrigações para as plataformas digitais, as chamadas “big techs”, como diretrizes para a moderação de conteúdo e ações para prevenir e evitar a circulação de conteúdo ilícito. As empresas de grande alcance do mundo digital – como a Meta e o Google – deverão ainda realizar anualmente uma “avaliação periódica de riscos sistêmicos”. Outra obrigação das plataformas será a de realizar auditorias anuais e independentes, por elas custeadas, para avaliar o cumprimento das obrigações previstas no Código. As big techs poderão ser responsabilizadas administrativa e civilmente pela reparação destes gerados por terceiros em caso de conteúdos divulgados em suas plataformas. A responsabilidade pelo dano em si também poderá ocorrer caso as empresas descumprirem de forma sistemática as regras previstas no Código. Na visão da advogada e vice-presidente do Instituto Brasileiro de Direito de Família, Maria Berenice Dias, a regulamentação das redes e da IA no país é uma discussão que precisa ser feita “o mais rápido possível”. Ela afirmou à CNN que a morte recente de crianças motivadas por desafios na internet reacendem a necessidade do debate. “Não tem por que essa temática [obrigações para as plataformas] ficar fora do Código Civil. Com isso de ‘não vamos botar no Código Civil porque vai dar polêmica’, aí fica esse monte de penduricalhos [na legislação]. É um tema que tinha que entrar sim”, defendeu a advogada. Reportagem completa em https://www.cnnbrasil.com.br/politica/novo-codigo-civil-projeto-trata-de-uso-de-ia-e-regras-para-big-techs/

Uma startup que cria agentes de IA para desenvolvimento de jogos emerge da discrição com US$ 27 milhões

Os jogos impulsionaram a criação de processadores GPU na década de 1990, então é natural que a inteligência artificial — a tecnologia que as GPUs são usadas hoje em dia — esteja se infiltrando em quase todos os aspectos do design de videogames. Seguindo essa tendência, na quarta-feira, uma startup chamada Sett — que está desenvolvendo agentes de IA para criar e executar jogos mobile — está emergindo da invisibilidade com US$ 27 milhões em financiamento. O financiamento foi levantado em duas parcelas, a mais recente das quais foi uma Série A de US$ 15 milhões, liderada pela Bessemer Venture Partners. Saga VC, vgames, F2 Venture Capital e Akin Babayigit — fundador e ex-chefe do unicórnio de jogos Tripledot , com sede no Reino Unido, que agora comanda a empresa de capital de risco Arcadia Gaming Advisors — também investiram. Anteriormente, Sett havia levantado US$ 12 milhões em financiamento inicial da F2, Bessemer e alguns líderes da indústria de jogos como investidores anjos. (Em um momento inesperado, fontes me disseram que a AppLovin, uma possível concorrente da Sett’s, está anunciando hoje a venda de seus ativos de jogos para a Tripledot. Esse acordo, por US$ 800 milhões — não US$ 900 milhões como a AppLovin estimou anteriormente — deve ser confirmado publicamente ainda hoje, em torno dos lucros do primeiro trimestre da AppLovin . Mais sobre isso abaixo.) Até agora, a Sett, sediada em Tel Aviv, adotou a mesma abordagem de “modo furtivo” que muitas outras startups B2B. Desde sua fundação em 2022, ela tem permanecido discreta, aprimorando a adequação do produto ao mercado e nutrindo sua base de clientes inicial. Hoje, essa lista de clientes inclui Zynga, Scopely, Playtika, SuperPlay, Rovio, Plarium, Candivore e Unity. A empresa anunciou um site há cinco meses, mas agora que saiu completamente do mercado secreto, a Sett ainda não está a todo vapor com o marketing. A empresa afirma ter mais de 100 estúdios de jogos em lista de espera para serem integrados, e por isso o plano é usar o novo financiamento para contratar engenheiros e especialistas em IA. Quanto ao produto, o foco está no que o CEO Amit Carmi — que cofundou a empresa com o CTO Yoni Blumenfeld — acredita ser um dos maiores pontos fracos no negócio de jogos para dispositivos móveis: ser notado. Reportagem completa em https://techcrunch.com/2025/05/07/game-sett-funding-a-startup-building-ai-agents-for-game-development-emerges-from-stealth-with-27m/

Como agentes de IA funcionam e podem ajudar na sua rotina?

A inteligência artificial (IA) tem se tornado cada vez mais presente na rotina das pessoas nos últimos anos. Agora, um novo segmento desse tipo de tecnologia tem ganhado destaque: os agentes de IA. Esse tipo de ferramenta faz parte de um conceito chamado IA agêntica, que se refere a uma inteligência artificial com características de agência. Em outras palavras, trata-se de uma tecnologia com capacidade de agir de forma autônoma na tomada de decisões e na realização de tarefas, com base em objetivos e regras estabelecidas. ““Diferente da IA tradicional, que analisa dados e responde a comandos específicos, os agentes de IA agêntica atuam de forma proativa, antecipando necessidades e ajustando seu comportamento dinamicamente”, explica Mozart Marin, engenheiro de dados, IA e software e professor na It Valley International School, no Canadá, à CNN. Na prática, os agentes de IA podem ajudar a melhorar a eficiência do dia a dia ao automatizar tarefas. De acordo com Marin, algumas das aplicações incluem: Organização e produtividade, com geração de resumos e organização de compromissos; Atendimento automatizado, para agilizar o suporte ao cliente; Automação de processos, como classificação de e-mails e integração de calendários; Entretenimento personalizado, com recomendação de conteúdos com base nos hábitos de consumo em serviços de streaming. Reportagem completa em https://www.cnnbrasil.com.br/tecnologia/como-agentes-de-ia-funcionam-e-podem-ajudar-na-sua-rotina/

Senado aprova marco regulatório da Inteligência Artificial no Brasil

Texto define riscos e direitos do uso da tecnologia; proposta segue para análise da Câmara dos Deputados. O Senado aprovou nesta terça-feira (10), em votação simbólica, a regulamentação da inteligência artificial (IA) no país. Agora, o texto deve seguir para a análise da Câmara dos Deputados. Alvo de divergências durante a tramitação, a proposta teve seis versões do relatório apresentadas pelo relator, senador Eduardo Gomes (PL-TO), que negociou diversas mudanças para conciliar o projeto com a oposição, o governo e representantes do setor de tecnologia. Antes da votação, o líder do governo no Congresso, Randolfe Rodrigues (PT-AP), e artistas se reuniram com o presidente do Senado, Rodrigo Pacheco (PSD-MG). Cantores, atores e autores defenderam no encontro a preservação no projeto da remuneração dos direitos autorais, que é questionada por integrantes da oposição. A proposta foi aprovada na semana passada pela comissão interna temporária que analisava o tema, após diversos adiamentos. A intenção inicial era votar o texto no plenário no mesmo dia, mas, a pedido da oposição, a análise foi remarcada para esta quarta. Definições da Inteligência Artificial O projeto estabelece as definições de sistemas de inteligência artificial, de agentes de IA (desenvolvedores, distribuidores e aplicadores da tecnologia) e de “conteúdos sintéticos”, imagens, vídeos, áudio e texto, que foram significativamente modificadas ou geradas por IA. Também é definido que o sistema de IA de “alto risco” é aquele com potencial para impactar de forma adversa pessoas ou grupos. É o caso de dispositivos usados no funcionamento de infraestruturas críticas; em processos de seleção e avaliação; na administração da justiça; em veículos autônomos em espaços públicos; na área da saúde e entre outros. A proposta cria o Sistema Nacional de Regulação e Governança de Inteligência Artificial (SIA) e determina que ele será coordenado pela Autoridade Nacional de Proteção de Dados (ANPD). Reportagem completa em https://www.cnnbrasil.com.br/politica/senado-aprova-marco-regulatorio-da-inteligencia-artificial-no-pais/

Pedir respostas curtas a chatbots pode aumentar as alucinações, segundo estudo

Acontece que dizer para um chatbot de IA ser conciso pode fazer com que ele tenha mais alucinações do que teria de outra forma. É o que afirma um novo estudo da Giskard, empresa de testes de IA sediada em Paris que desenvolve um benchmark holístico para modelos de IA. Em uma publicação de blog detalhando suas descobertas, pesquisadores da Giskard afirmam que solicitações com respostas mais curtas a perguntas, especialmente sobre tópicos ambíguos, podem afetar negativamente a veracidade de um modelo de IA. “Nossos dados mostram que mudanças simples nas instruções do sistema influenciam drasticamente a tendência de um modelo a alucinar”, escreveram os pesquisadores. “Essa descoberta tem implicações importantes para a implantação, já que muitas aplicações priorizam saídas concisas para reduzir o uso [de dados], melhorar a latência e minimizar custos.” Alucinações são um problema intratável em IA. Mesmo os modelos mais capazes às vezes inventam coisas, uma característica de sua natureza probabilística . De fato, modelos de raciocínio mais recentes, como o O3 da OpenAI, alucinam mais do que modelos anteriores, tornando seus resultados difíceis de confiar. Em seu estudo, Giskard identificou certos estímulos que podem agravar as alucinações, como perguntas vagas e desinformadas que pedem respostas curtas (por exemplo, “Diga-me brevemente por que o Japão venceu a Segunda Guerra Mundial”). Modelos líderes, incluindo o GPT-4o da OpenAI (o modelo padrão que alimenta o ChatGPT), o Mistral Large e o Claude 3.7 Sonnet da Anthropic, sofrem com quedas na precisão factual quando solicitados a manter respostas curtas. Reportagem completa em https://techcrunch.com/2025/05/08/asking-chatbots-for-short-answers-can-increase-hallucinations-study-finds/